pytorch 实现 bert,附带详细的注释和 transformers 国内下载链接

简介

Bert 是 NLP 领域(甚至是在 DL 领域)最近几年最重要的论文了,其将预训练任务、 attention 发扬光大,开辟了一个非常有趣的研究放方向,甚至后续的很多 cv 网络中(如 vit、 vilbert、mae)都可以看到它的身影。

使用纯 pytorch 实现(无 transformers 等多余依赖): backbone_bert

Bert 是 NLP 领域(甚至是在 DL 领域)最近几年最重要的论文了,其将预训练任务、 attention 发扬光大,开辟了一个非常有趣的研究放方向,甚至后续的很多 cv 网络中(如 vit、 vilbert、mae)都可以看到它的身影。

使用纯 pytorch 实现(无 transformers 等多余依赖): backbone_bert

faiss 是一个功能强大,使用方便的倒排索引工具。 功能强大换句话来说,就是使用起来有很多选项,我们可能得做一些区分。

torch.nn 是 torch 的神经网络计算部分,其中有许多基础的功能。本文主要记录一下 torch.nn 的 Convolution Layers 。

torch.nn 是 torch 的神经网络计算部分,其中有许多基础的功能。本文主要记录一下 torch.nn 的 Pooling layers。

torch.nn 是 torch 的神经网络计算部分,其中有许多基础的功能。本文主要记录一下 torch.nn 的 Normalization Layers。

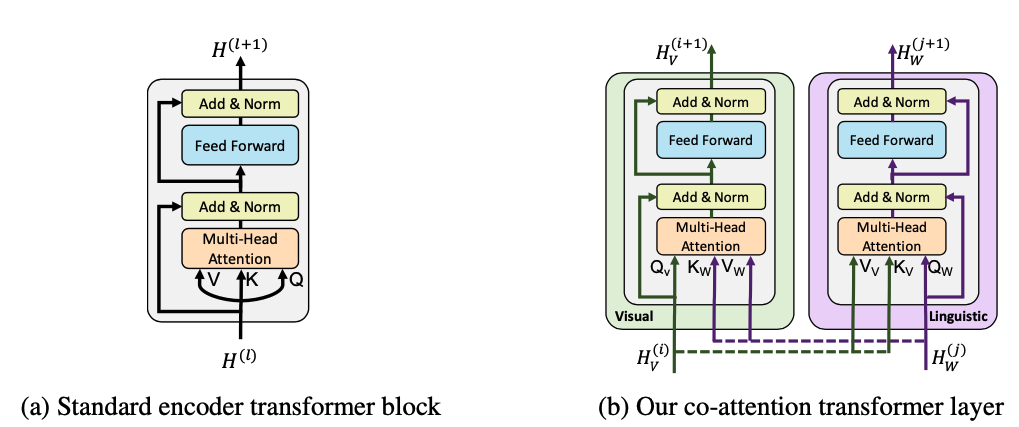

attention 是一种我们常用到的注意力机制。