Logistic 回归

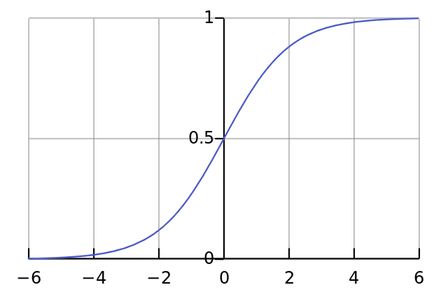

最近看到了Logistic regression,LR模型主要用于分类模型(不是回归),细心的人不难发现LR模型在线性回归模型上加了一个sigmoid转换。

sigmoid转换的优势

- 求梯度方便

- 数据统一分布在0-1之间,从下面的LR分布也可以看出

算法

定义

$P(y=1\mid x)=\dfrac{e^{wx+b} }{1+e^{wx+b} }$

$P(y=0\mid x)=\dfrac{1}{1+e^{wx+b} }$

扩张一下$w,x$,令 $wx+b$->$wx$

$P(y=1\mid x)=\dfrac{e^{wx} }{1+e^{wx} }$

$P(y=0\mid x)=\dfrac{1}{1+e^{wx} }$

对数几率

$p$指发生概率

若将 p 作为正例的可能性,则 1-p 为其负例的可能性,两者的比值为: $\dfrac{p}{1-p}$ 成为”几率”,反映了作为正例的相对可能性,对几率取对数则得到 对数几率(log odds,或称logit)。

由此可以看出,上式实际上使用线性回归模型的预测结果去毕竟真实标记的对数概率,因此该模型被称为 对数几率回归(logistic regression)。

注意名字虽然叫回归,但其实是分类学习方法。

$p$ 代入 $P(y=1\mid x)$

把$P(y=1\mid x)$领出来,

极大似然估计

跟上边学到的貌似是一回事

小结

从图像中可以看出,逻辑回归函数将输入的$(-\infty, \infty)$空间映射到了$(0,1)$空间,即将值域限制在了$(0,1)$之内。 限制后的假设函数为:

Logistic 回归